近日,UT奥斯丁等机构提出的StreamingT2V技术引发了广泛关注,将AI视频生成推向了新的高度。这项技术突破了以往视频长度的限制,实现了生成高度一致且长度可扩展的视频。

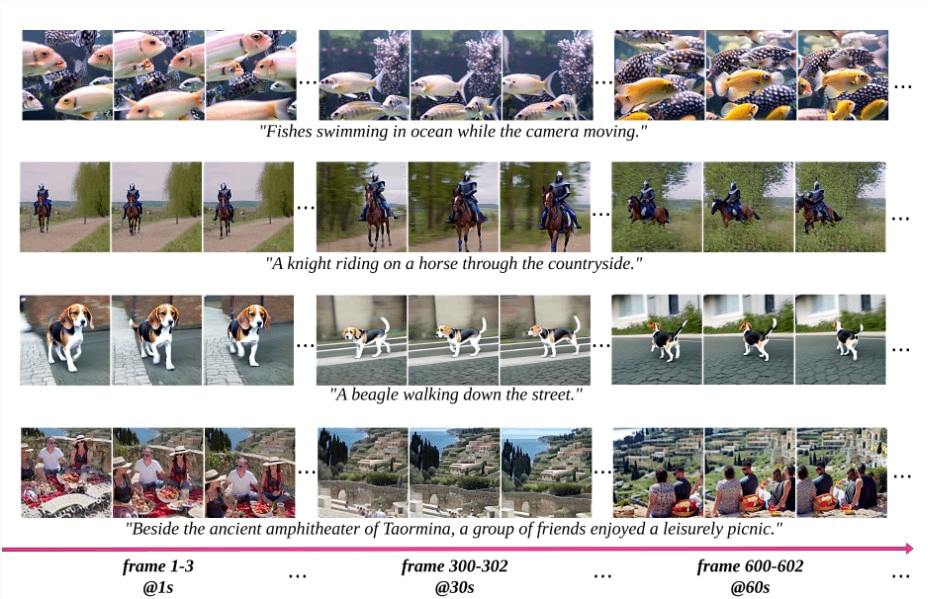

StreamingT2V技术的核心构架包括条件注意力模块(CAM)和外观保持模块(APM)。CAM利用短期记忆单元确保视频连续性,而APM作为长期记忆单元保持视频中对象或场景的一致性。这两个模块的结合,使得生成的视频不仅动态连贯,而且视觉效果高质量。在测试中,研究人员用Streaming T2V生成1200帧,长达2分钟的视频。

具体实现方法分为三个阶段:初始化、Streaming T2V生成和Streaming Refinement。在初始化阶段,利用文本到视频模型创造视频的前16帧;接着进入Streaming T2V阶段,通过自回归技术生成后续帧,保证视频内容连贯性;最后,在Streaming Refinement阶段对生成的视频进行优化,提高画质和动态效果。

特色亮点包括:

从文本描述生成2分钟的视频

创建具有复杂动态运动的视频

确保长视频中的时间一致性

该技术的出现标志着AI视频生成的新突破,不仅可以生成1200帧甚至无限长的视频,而且内容过渡自然平滑,丰富多样。与此同时,StreamingT2V技术的不断完善和提升也将进一步推动AI视频生成领域的发展,为视频内容创作提供更多可能性。

项目入口:https://github.com/Picsart-AI-Research/StreamingT2V

论文地址:https://arxiv.org/abs/2403.14773

本文来源于#站长之家,由@ai资讯 整理发布。如若内容造成侵权/违法违规/事实不符,请联系本站客服处理!

该文章观点仅代表作者本人,不代表本站立场。本站不承担相关法律责任。

如若转载,请注明出处:https://www.zhanid.com/news/840.html