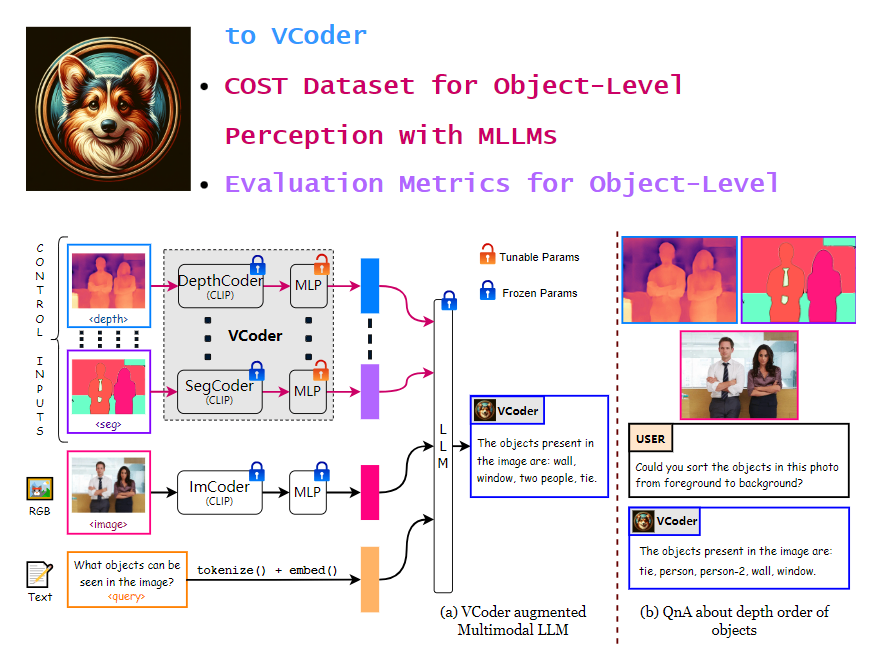

VCoder是一个视觉编码器,旨在提高多模态语言模型(MLLM)在识别图像中的对象和理解图像场景方面的能力。它能够帮助模型更好地理解和分析图像内容。

项目地址:https://github.com/SHI-Labs/VCoder

该编码器具有多项功能。首先,它能够增强视觉感知能力,通过提供额外的视觉编码器,使MLLM能够更好地理解和分析图像内容。其次,VCoder能够处理特殊类型的图像,例如分割图和深度图。分割图能够帮助模型识别和理解图像中不同物体的边界和形状,而深度图则提供了物体距离相机远近的信息。最后,VCoder改善了对象感知任务的表现。通过提供额外的感知模态输入,如分割图或深度图,它显著提高了MLLM的对象感知能力,包括更准确地识别和计数图像中的对象。

在实验中,VCoder与开源的多模态LLMs(如MiniGPT-4、InstructBLIP、LLaVA-1.5和CogVLM)进行了比较,并在COST验证集上进行了测试。实验结果表明,VCoder在对象识别任务中表现最佳,特别是在对象计数和识别方面优于基线模型。在处理复杂场景中的对象计数和识别任务时,VCoder展现出更高的准确性,尤其是在场景中有许多实体时。

与GPT-4V进行比较时,实验发现GPT-4V在所有对象识别任务中表现一致,但在对象级感知方面落后于VCoder。

VCoder作为一个视觉编码器,为MLLM提供了更好的视觉感知能力,能够处理特殊类型的图像,并改善了对象感知任务的表现。在与其他模型的比较中,VCoder在对象计数和识别方面表现出色,特别是在复杂场景中。

本文来源于#站长之家,由@zhanid 整理发布。如若内容造成侵权/违法违规/事实不符,请联系本站客服处理!

该文章观点仅代表作者本人,不代表本站立场。本站不承担相关法律责任。

如若转载,请注明出处:https://www.zhanid.com/news/431.html