随着人工智能技术的迅猛发展,文本到图像生成技术已经成为了一个热门的研究领域。然而,现有的生成方法往往难以满足人们对视觉内容的细粒度偏好。为了应对这一挑战,吴绍金、丁飞、黄梦琪、刘炜和千合等人提出了VMix,这是一种新颖的即插即用适配器,旨在系统地弥合生成图像和现实世界中各种美学维度对应物之间的美学质量差距。

功能特色

细粒度美学控制

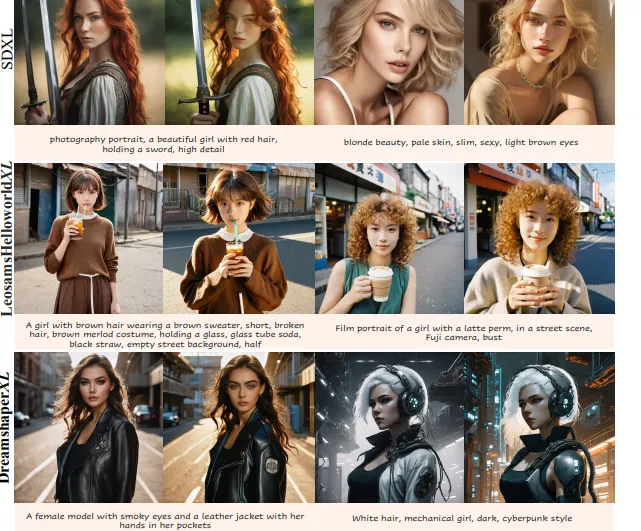

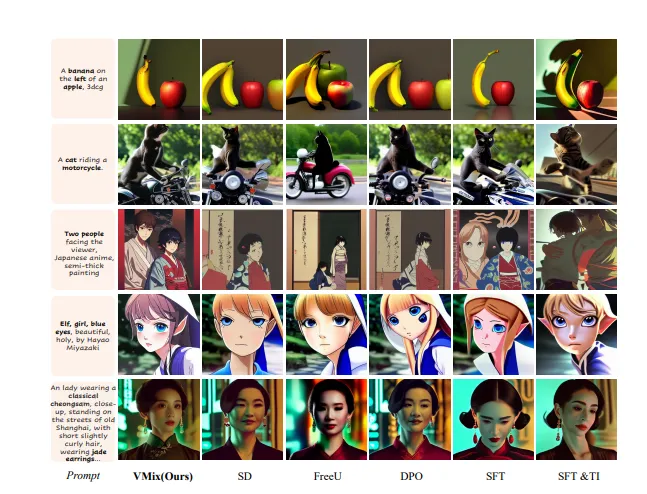

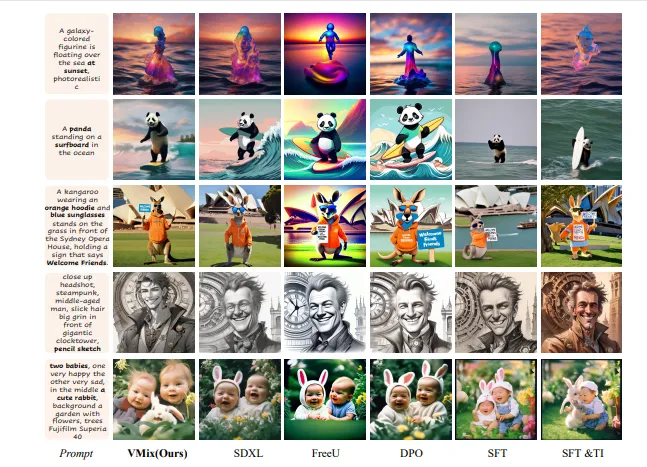

VMix的核心优势在于其能够实现细粒度的美学控制。具体来说,通过调整美学嵌入(aesthetic embedding),VMix可以在特定的美学维度上显著提升图像的质量。例如,当使用单维美学标签时,可以观察到图像在特定维度上的质量有所改善;而当使用全正向美学标签时,生成的图像整体视觉效果优于基线模型。

即插即用适配器

VMix设计为一个即插即用的适配器,可以轻松集成到现有的文本到图像生成模型中。这种灵活性使得VMix可以广泛应用于不同的生成模型,而无需对原有模型进行大规模的修改。

多样化的美学维度

VMix支持多种美学维度的控制,包括自然光、情感、纹理、颜色等。这些维度的组合使用可以生成更加丰富多彩和高质量的图像,满足不同用户的需求。

技术细节

初始化阶段

在初始化阶段,预定义的美学标签通过CLIP(Contrastive Language–Image Pretraining)模型转换为[CLS] tokens,从而获得AesEmb(美学嵌入)。这一过程只需在训练开始时处理一次,大大提高了效率。

训练阶段

在训练阶段,VMix首先通过一个投影层将输入的美学描述undefined映射为与内容文本嵌入undefined相同维度的嵌入undefined。然后,文本嵌入undefined通过值混合交叉注意力机制(value-mixed cross-attention)集成到去噪网络中。这一过程使得模型能够在生成图像时充分考虑美学嵌入的影响。

推理阶段

在推理阶段,VMix从AesEmb中提取所有正向的美学嵌入,形成美学输入,并与内容输入一起送入模型进行去噪过程。这一过程确保了生成的图像在多个美学维度上都表现出色。

具体实现

美学嵌入的生成

预定义美学标签:定义一组美学标签,如“自然光”、“情感”、“纹理”、“颜色”等。

CLIP转换:使用CLIP模型将这些美学标签转换为[CLS] tokens,生成AesEmb。

投影层

输入美学描述:用户输入具体的美学描述,如“自然光充足”、“情感温暖”等。

映射为嵌入:通过投影层将输入的美学描述映射为与内容文本嵌入相同维度的嵌入undefined。

交叉注意力机制

值混合交叉注意力:将内容文本嵌入undefined和美学嵌入undefined通过值混合交叉注意力机制集成到去噪网络中。

生成图像:最终生成的图像在多个美学维度上表现出色。

应用场景

个性化图像生成

VMix可以用于个性化图像生成,根据用户的特定需求生成高质量的图像。例如,用户可以通过指定不同的美学标签来生成符合自己喜好的图像,如“自然光充足”的夏日肖像、“情感温暖”的家庭照片等。

艺术创作

艺术家可以利用VMix生成具有特定风格和美学特征的艺术作品。通过调整不同的美学维度,艺术家可以探索更多的创意可能性,创造出独特的艺术作品。

商业应用

在商业领域,VMix可以用于生成高质量的产品宣传图、广告海报等。通过精确控制图像的美学特征,企业可以更好地吸引目标客户,提高品牌影响力。

教育培训

在教育培训领域,VMix可以用于生成教学材料中的插图和示意图。通过控制图像的美学特征,教师可以制作出更具吸引力和教育意义的教学资源。

相关链接

论文链接:https://arxiv.org/abs/2412.20800v1

GitHub仓库:https://github.com/fenfenfenfan/VMix

总结

VMix作为一种新颖的即插即用适配器,通过细粒度的美学控制显著提升了文本到图像生成模型的性能。其灵活的设计和强大的功能使其在个性化图像生成、艺术创作、商业应用和教育培训等多个领域具有广泛的应用前景。未来,随着技术的进一步发展,VMix有望成为文本到图像生成领域的标准工具之一,为用户提供更加丰富和高质量的视觉内容。

本文由@ai资讯 原创发布。

该文章观点仅代表作者本人,不代表本站立场。本站不承担相关法律责任。

如若转载,请注明出处:https://www.zhanid.com/news/3028.html