EchoMimic是什么

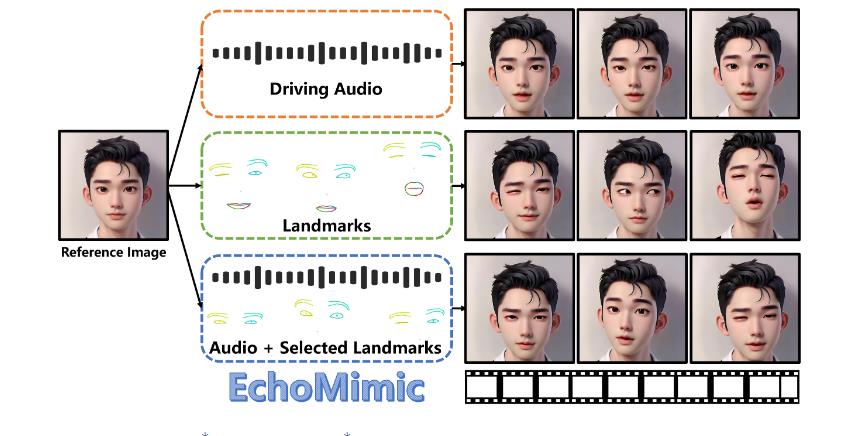

EchoMimic是阿里巴巴达摩院推出的一款AI音频驱动图片说话开源项目,专注于通过先进的深度学习技术将静态图像转化为具有动态语音和表情的数字人像。这项技术的核心在于它能够根据音频输入,实时生成与语音同步的口型和面部表情,从而创造出逼真的动态肖像视频。相较于传统的数字人像生成技术,EchoMimic不仅解决了对音频或面部关键点过度依赖的问题,还通过创新的技术手段,提供了一种更为自然、流畅的数字人像生成方案。

功能特色

EchoMimic的功能特色主要体现在以下几个方面:

口型同步生成

EchoMimic能够根据输入的音频和面部照片,创造出口型动作与语音完美匹配的视频。这一功能通过高精度的音频特征提取和面部标志点定位,结合深度学习模型,生成与语音同步的逼真面部表情和口型。这种同步性不仅限于普通对话,还能处理多种语言和风格,包括普通话、英语以及歌唱等。

自然逼真

EchoMimic生成的面部动画非常符合真实的面部运动和表情变化。它融合了音频和面部特征,使得生成的动画看起来自然流畅,不易察觉出人工合成的痕迹。这种自然逼真的效果得益于其多模态学习策略和创新的训练方法,通过音频和面部关键点的双重训练,提升了动画的真实性和表现力。

多语言支持

EchoMimic不仅支持普通话,还能处理英语和歌唱等多种语言和风格。这一功能使得EchoMimic在跨国交流和多语言环境中具有广泛的应用前景。无论是制作多语言视频内容,还是为不同语言的用户提供服务,EchoMimic都能提供高质量的口型同步和面部表情生成。

创新训练与实时处理

EchoMimic采用创新训练策略,结合预训练模型,实现快速适应新音频并实时生成动画。这种训练策略不仅提高了生成动画的速度和效率,还增强了模型的泛化能力,使其能够处理更多样化的音频和面部特征。

技术细节

音频特征提取:EchoMimic利用音频处理技术分析语音的节奏、音调等特征。这些特征被用于生成与语音同步的面部表情和口型。音频特征提取的准确性和精度对于生成高质量的动画至关重要。

面部标志点定位:EchoMimic使用高精度面部识别算法定位关键面部区域,包括眼睛、嘴巴、鼻子等。这些标志点被用于生成与语音同步的面部动画。面部标志点定位的准确性和稳定性对于生成逼真的动画至关重要。

多模态融合与动画生成:EchoMimic结合音频特征与面部信息,通过深度学习模型(如CNN、RNN、GAN)生成与语音同步的逼真面部表情和口型。这些模型通过训练学习音频和面部特征之间的关联,从而能够生成高质量的动画。

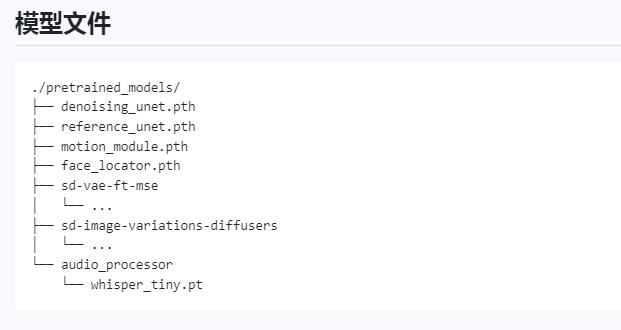

去噪U-Net:去噪U-Net是EchoMimic的核心组件之一,用于增强在不同条件下由噪声破坏的多帧潜在表示。它通过在每个Transformer中加入三个不同的注意力层,包括参考注意层、音频注意层和时间注意层,实现了对空间和时间关系的细微理解和集成。这种增强有助于提升生成动画的清晰度和连贯性。

Reference U-Net:Reference U-Net用于编码参考图片,确保在生成过程中保持面部身份和背景一致性。它与去噪U-Net并行运行,并通过自注意力机制提取参考图像特征。这些特征被用作去噪U-Net中相应Transformer块参考注意力层中的键和值输入。

地标编码器:地标编码器负责将每个面部地标图像编码为与潜在空间维度对齐的特征表示。这些特征在摄取到去噪U-Net之前通过元素相加直接与多帧潜伏期集成。地标编码器能够无缝地结合精确的空间信息,这对于在生成过程中保持准确的解剖结构和运动至关重要。

时间注意层:时间注意层用于编码视频数据中固有的时间动态。它通过重塑隐藏状态并沿帧序列的时间轴应用自我注意机制,捕捉连续帧之间的复杂依赖关系。时间注意层能够识别和学习细微的运动模式,确保合成帧中的平滑和谐过渡。

应用场景

EchoMimic在多个领域具有广泛的应用前景,包括但不限于以下几个方面:

娱乐产业:EchoMimic可用于制作虚拟偶像、动画角色等娱乐内容。通过输入音频和面部照片,可以生成逼真的动态肖像视频,为观众带来更加沉浸式的娱乐体验。

在线教育:EchoMimic可用于在线教育领域,为学生提供更加生动、形象的教学内容。通过生成教师的动态肖像视频,可以提高学生的学习兴趣和参与度,提升教学效果。

影视制作:EchoMimic可用于影视制作中的特效处理。通过生成逼真的口型同步和面部表情动画,可以节省大量的人工制作时间和成本,提高制作效率和质量。

游戏开发:EchoMimic可用于游戏开发中的角色动画制作。通过输入角色的音频和面部照片,可以生成逼真的动态表情和口型,提升游戏的真实感和表现力。

社交媒体:EchoMimic可用于社交媒体平台的动态头像制作。用户可以通过上传自己的照片和音频,生成个性化的动态头像,增加社交互动的趣味性和互动性。

相关官方链接

项目主页:项目主页链接

GitHub仓库:GitHub仓库链接

总结

EchoMimic作为一款创新的AI项目,通过先进的深度学习技术将静态图像转化为具有动态语音和表情的数字人像。其口型同步生成、自然逼真、多语言支持等功能特色使得EchoMimic在娱乐产业、在线教育、影视制作、游戏开发、社交媒体等多个领域具有广泛的应用前景。

EchoMimic的技术细节包括音频特征提取、面部标志点定位、多模态融合与动画生成等方面。其中,去噪U-Net、Reference U-Net、地标编码器、时间注意层等核心组件的引入,使得EchoMimic能够生成高质量的动态肖像视频。

EchoMimic作为一款创新的AI项目,具有广泛的应用前景和巨大的市场潜力。随着技术的不断进步和应用场景的不断拓展,EchoMimic将为人类社会带来更多智能、高效、逼真的数字人像生成解决方案。

本文由@ai资讯 原创发布。

该文章观点仅代表作者本人,不代表本站立场。本站不承担相关法律责任。

如若转载,请注明出处:https://www.zhanid.com/news/2155.html