大型语言模型(LLM)是人工智能领域最新的引入,已经席卷全球。这些模型以其令人难以置信的能力,被人们广泛使用,无论是研究人员、科学家还是学生。凭借其仿人潜力回答问题、生成内容、概括文本、完成代码等方面,这些模型已经走过了很长的路程。

LLM 在情感分析、智能聊天机器人和内容创作等多个领域都有所需。由于使用了大量的计算资源,因此为了增加吞吐量,GPU 资源被有效地利用,通过批处理多个用户请求来提高内存效率和计算能力。为了实现这一点,使用了 LLM 量化技术。然而,现有的量化方法,如8位权重 - 激活量化,并没有充分利用新一代 GPU 的能力。由于这些 GPU 上的整数操作符是4位的,当前的量化技术并不是为了实现最大的效率而设计的。

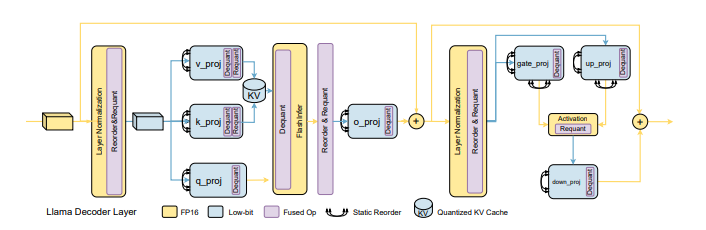

为了解决这个问题,一组研究人员引入了 Atom,一种新的方法,旨在最大化 LLM 的服务吞吐量。Atom 是一种低比特量化技术,通过使用低比特操作符和低比特量化来减少内存使用,从而显著提高吞吐量而不损失准确性。它使用了细粒度和混合精度量化的特殊组合,以保持卓越的准确性。

研究团队表示,Atom 在服务时已经在4位权重 - 激活量化配置方面进行了评估。结果显示,与典型的16位浮点(FP16)方法相比,Atom 可以在保持相同目标范围内的延迟的同时,提高端到端吞吐量最多7.73倍;相对于8位整数(INT8)量化,提高了2.53倍。这使得 Atom 成为满足对 LLM 服务需求不断增长的可行解决方案,因为它保持了所需的响应时间水平,并大大提高了 LLM 处理请求的速度。

研究人员总结了 Atom 的主要贡献如下:

1. 彻底分析了 LLM 服务作为该研究性能分析的第一步。确定了使用低比特权重 - 激活量化方法带来的重要性能优势。

2. 提出了一种独特而精确的低比特权重 - 激活量化技术 Atom。

3. Atom 采用了多种策略来确保最佳性能。它使用了混合精度,对剩余的关键激活和权重使用降低的精度,同时保持前者的准确性。使用细粒度组量化来减少量化过程中的错误。Atom 还采用了动态激活量化,通过适应每个输入的独特分布来减少量化错误。为了进一步提高整体性能,该方法还处理了 KV-cache 的量化。

研究还提出了一个长期管理(LLM)服务的集成框架。该团队共同设计了一个有效的推理系统,构建了低比特 GPU 核心,并展示了 Atom 在实际环境中有用的端到端吞吐量和延迟。

对 Atom 的性能进行了全面评估,结果显示 Atom 极大地提高了 LLM 服务的吞吐量,吞吐量增益最多可达到7.7倍,同时仅有微小的准确性损失。

论文地址:https://arxiv.org/abs/2310.19102

本文来源于#站长之家,由@tom 整理发布。如若内容造成侵权/违法违规/事实不符,请联系本站客服处理!

该文章观点仅代表作者本人,不代表本站立场。本站不承担相关法律责任。

如若转载,请注明出处:https://www.zhanid.com/news/100.html